Windows 11将很快利用GPU进行生成式AI,助力AI技术的突破

新版本将引入对大型新语言模型的支持,这将使要求高的AI工作负载更加易用。尤其值得一提的是,它与OpenAI的Chat API兼容,这意味着使用RTX GPU的PC和工作站可以在本地执行(而不是云端)任务,并且最低只需8GB的VRAM。

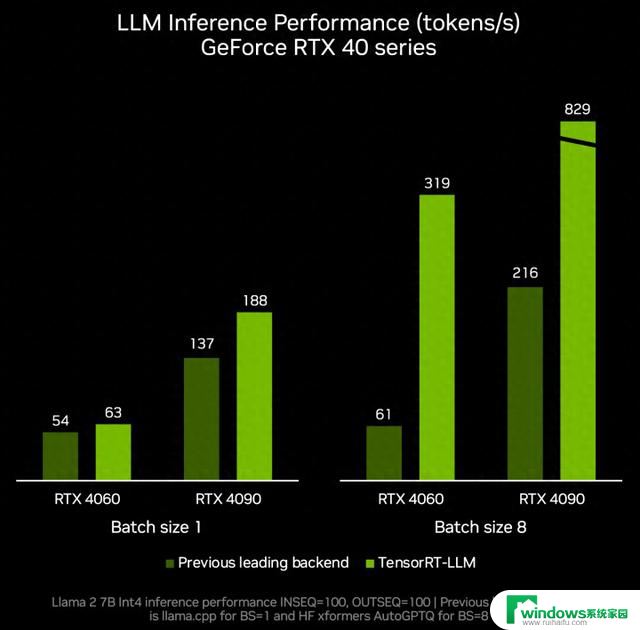

Nvidia的TensorRT-LLM库上个月刚刚发布,据说可以帮助提高使用RTX图形卡上的Tensor Cores的超大语言模型(LLMs)的性能。它为开发人员提供了一个Python API,可以更快地定义LLM和构建TensorRT引擎,而无需深入了解C++或CUDA。

随着TensorRT-LLM v0.6.0的发布,由于引入了AI工作台,自定义生成式AI项目的复杂性将得到简化。这是一个统一的工具包,有利于快速创建、测试和自定义预训练的生成式AI模型和LLM。该平台还预计将使开发人员能够简化协作和部署工作,确保模型开发的效率和可扩展性。

鉴于支持AI开发人员的重要性,英伟达和微软也发布了DirectML增强版。这些优化加速了像Llama 2和Stable Diffusion这样基础的人工智能模型,为开发者提供了在多个厂商间进行部署的选择,同时提高了性能标准。

新款TensorRT-LLM库更新还允诺在推理性能上实现大幅提高,速度提升高达五倍。此次更新还扩大了对其他流行的LLM的支持,包括Mistral 7B和Nemotron-3 8B,并将快速、准确的本地LLM功能扩展到更广泛的便携式Windows设备。

通过一个新包装器,将TensorRT-LLM与OpenAI的Chat API集成,这将允许数百个搭载RTX的PC本地运行由AI驱动的项目和应用。这可能会消除对云服务的依赖,并确保Windows 11 PC上私人和专有数据的机密性。

在Windows 11 PC上,人工智能的未来还有很长的路要走。随着人工智能模型的不断涌现和开发人员的持续创新,利用NVIDIA RTX GPU的强大功能可能会成为改变游戏规则的因素。然而,微软是否能够将这块拼图恰到好处地用在Windows PC上以充分释放人工智能的能力,现在还言之过早。