微软限制员工使用ChatGPT,担忧数据泄露问题:如何保护企业信息安全?

ChatGPT是一款由OpenAI开发的人工智能语言模型,它能够理解和生成人类语言。已经在各种应用中展现出了强大的能力。然而任何技术的应用都伴随着一定的风险,尤其是在涉及到大量敏感信息的处理时。微软作为全球最大的科技公司之一,对数据安全和隐私保护的重视自然是无可厚非的。

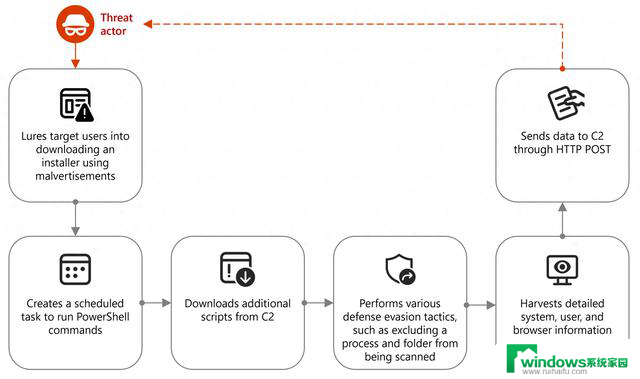

据了解,微软并未完全禁止员工使用ChatGPT,而是对其进行了一定的限制。这主要是基于对ChatGPT可能带来的数据泄露风险的担忧。尽管OpenAI已经采取了一系列的安全措施来防止这种情况的发生,但是微软仍然选择了谨慎的态度。

微软的这一决定引发了业界的广泛关注。一方面,人们对微软对数据安全的高度重视表示赞赏;另一方面,也有人对ChatGPT的应用前景表示担忧。一些业内人士认为,微软的这一决定可能会对AI技术的发展产生一定的影响。

然而,我们也需要注意到,数据安全和隐私保护是任何技术应用都必须面对的问题。无论是AI技术还是其他技术,都需要在保障用户利益的前提下进行发展。微软的这一决定,无疑是对这一原则的坚守。

总的来说,微软禁止员工使用ChatGPT的决定,是在权衡了各种因素后做出的。这一决定既体现了微软对数据安全和隐私保护的重视,也反映了其在面对新技术挑战时的谨慎态度。我们期待微软能够在保障数据安全的同时,继续推动AI技术的发展。